Lassen Sie den Kraken frei: Künstliche Intelligenz leicht in jedes industrielle System bringen

Es besteht ein weit verbreitetes Interesse am Einsatz von Anwendungen der künstlichen Intelligenz (KI) und des maschinellen Lernens (ML) in industriellen Umgebungen, um die Produktivität und Effizienz zu steigern und gleichzeitig Einsparungen bei den Betriebskosten zu erzielen. Wie Ihnen jeder Ingenieur oder technische Leiter sagen wird, gibt es jedoch drei Hauptprobleme, die im Hinblick auf das Hinzufügen von „Intelligenz" zu einer installierten Basis von „dummen“ Maschinen, von Motoren bis zu HVAC-Systemen, angegangen werden müssen.

Erstens gibt es nicht genug Leute mit KI- und ML-Expertise, um die Nachfrage zu befriedigen, und was an Experten zur Verfügung steht, ist nicht billig. Zweitens mangelt es an qualifizierten Datensätzen, mit denen die KI- und ML-Systeme trainiert werden können, und alle verfügbaren Datensätze werden eifersüchtig bewacht. Drittens haben AI- und ML-Systeme traditionell nach High-End-Verarbeitungsplattformen verlangt, auf denen sie laufen.

Was wir brauchen, ist ein Weg, der es bestehenden Ingenieuren und Entwicklern ohne KI- und ML-Erfahrung ermöglicht, schnell KI- und ML-Systeme zu erstellen und sie auf effizienten, kostengünstigen Mikrocontroller-Plattformen einzusetzen. Ein interessantes Startup namens Cartesiam.AI befasst sich mit seinem NanoEdge AI Studio mit all diesen Themen. Lassen Sie mich erklären, wie.

Quantifizierung des Aufstiegs von AI und ML

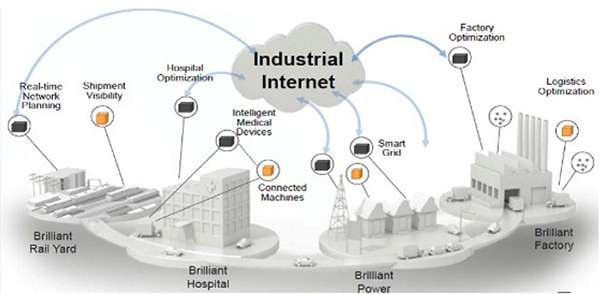

Bis Mitte 2020 wird je nach Quelle weltweit mit 20 bis 30 Milliarden Randgeräten1,2 gerechnet, wobei sich der Begriff „Randgerät“ auf angeschlossene Geräte und Sensoren bezieht, die sich am Rand des Internets (Netzwerkrand) befinden, wo sie mit der realen Welt verbunden sind. Von diesen werden nur etwa 0,3% mit KI- und ML-Fähigkeiten ausgestattet. Es wird ferner geschätzt, dass es bis 20253,4 zwischen 40 und 75 Milliarden solcher Geräte geben wird, bis zu diesem Zeitpunkt wird erwartet, dass mindestens 25% mit KI- und ML-Fähigkeiten ausgestattet sein müssen.

Ein wichtiger Faktor bei industriellen Einsätzen ist es, die vorhandenen „dummen“ Maschinen zu nehmen und sie durch die Ergänzung mit KI- und ML-Fähigkeiten „intelligent“ zu machen. Es ist schwierig, das Potenzial hier zu überschätzen; so wird beispielsweise geschätzt, dass es allein in den USA 6,8 Billionen Dollar an bestehender dummer (veralteter) Infrastruktur und Maschinerie gibt.5

Wie man am Netzwerkrand AI und ML effizienter machen kann

Das Internet der Dinge (IoT) und das industrielle IoT (IIoT) sind bereits allgegenwärtig, und viele Geräte werden bereits miteinander vernetzt - die nächste Herausforderung besteht darin, diese Geräte intelligent zu machen.

Die traditionelle Art und Weise, eine AI/ML-Anwendung zu erstellen, ist die Definition einer neuronalen Netzwerkarchitektur, einschließlich der Anzahl der neuronalen Schichten, der Anzahl der Neuronen pro Schicht und der Art und Weise, wie die verschiedenen Neuronen und Schichten miteinander verbunden werden. Der nächste Schritt ist der Zugriff auf einen qualifizierten Datensatz (dessen Erstellung selbst sehr viel Zeit und Ressourcen gekostet haben kann). Der Datensatz wird verwendet, um das Netzwerk in der Cloud zu trainieren (d.h. unter Verwendung einer großen Anzahl von High-End-Servern mit gigantischen Rechenkapazitäten). Schließlich wird das trainierte Netzwerk in eine Form übersetzt, die für den Einsatz im Edge-Gerät geeignet ist.

Laut dem IBM Quant Crunch Report6 sind Datenwissenschaft und -analyse (DSA) keine Schlagworte mehr, sondern wesentliche Geschäftswerkzeuge. Es wächst jedoch die Sorge, dass das Angebot an Menschen mit DSA-Fähigkeiten gefährlich hinter der Nachfrage zurückbleibt, wobei der Mangel an Datenwissenschaftlern derzeit allein in den USA bei 130.000 liegt.

Leider ist der fehlende Zugang zu qualifizierten Datenwissenschaftlern und qualifizierten Datensätzen ein Hindernis für die schnelle und erschwingliche Erstellung von AI/ML-fähigen intelligenten Geräten bzw. Objekten. Laut Cisco7, liegt die Misserfolgsrate bei IoT-Projekten im Allgemeinen bei etwa 74%, und diese Misserfolgsrate steigt bei AI/ML-fähigen Projekten an.

Nach Angaben des IDC8, gibt es weltweit etwa 22 Millionen Software-Entwickler. Von diesen konzentrieren sich etwa 1,2 Millionen auf eingebettete Systeme, und nur etwa 0,2 % von ihnen haben auch nur minimale AI/ML-Kenntnisse.

Einige AI- und ML-Systeme, wie z.B. die maschinelle Bildverarbeitung zur Objekterkennung und -identifizierung, erfordern den Einsatz spezieller High-End-Computerbausteine, einschließlich Grafikverarbeitungseinheiten (GPUs) und/oder feldprogrammierbarer Gate-Arrays (FPGAs). Neue Entwicklungen bei den AI/ML-Technologien bedeuten jedoch, dass die große Mehrheit der AI/ML-Anwendungen, die nicht zur Bildverarbeitung gehören, auf den relativ einfachen Mikrocontrollern eingesetzt werden können, die in eingebetteten Systemen vorherrschend sind.

Laut Statista9 werden sich die weltweiten Lieferungen von Mikrocontrollern im Jahr 2020 voraussichtlich auf etwa 28 Milliarden Einheiten (d.h. etwa 885 pro Sekunde) belaufen, was mikrocontrollerbasierte Plattformen zur am weitesten verbreiteten Hardware auf dem Markt macht. Mit ihren niedrigen Kosten und dem geringen Stromverbrauch sind Mikrocontroller die perfekte Plattform, um Intelligenz an den Netzwerkrand zu bringen.

Selbst für große Unternehmen mit Zugang zu Wissenschaftlern und Datensätzen und im Wesentlichen unbegrenzten Budgets ist es schwierig, sich in der KI und ML zurechtzufinden. Für kleinere Unternehmen kann es durchaus unmöglich sein. Wenn die Situation so bleibt, wie sie ist, ist es unmöglich, dass bis 2025 25% der Randgeräte mit AI/ML-Fähigkeiten ausgestattet werden. Wenn nur die vorhandenen Entwickler von Mikrocontroller-basierten eingebetteten Systemen für die Entwicklung von AI/ML-Anwendungen ausgerüstet wären...

Eine einfache, schnelle und erschwingliche Möglichkeit zur Entwicklung AI/ML-fähiger intelligenter Objekte

Die am weitesten verbreitete Rechenplattform für eingebettete Anwendungen in industriellen Umgebungen ist der Mikrocontroller, und kein Mikrocontroller ist allgegenwärtiger als die Cortex-M-Familie von Arm, insbesondere die M0, M0+, M3, M4 und M7.

Abbildung 1: Das V2M-MPS2-0318C ist eine leistungsstarke Entwicklungsplattform für Arm-Cortex-M-basierte Anwendungen mit viel I/O und einem LCD-Display. (Bildquelle: Arm)

Abbildung 1: Das V2M-MPS2-0318C ist eine leistungsstarke Entwicklungsplattform für Arm-Cortex-M-basierte Anwendungen mit viel I/O und einem LCD-Display. (Bildquelle: Arm)

Etwas, zu dem Unternehmen Zugang haben, sind die traditionellen Entwickler von Embedded-Systemen. Was wir brauchen, ist eine Möglichkeit, diese Entwickler dazu zu bringen, sich wie AI/ML-Experten zu verhalten, ohne sie ausbilden zu müssen. Die ideale Lösung wäre es, traditionellen Embedded-Entwicklern die Möglichkeit zu geben, schnell und einfach selbstbewusste Maschinen zu erstellen, die ihre Umgebung automatisch erkennen und verstehen, Muster und Anomalien erkennen sowie Probleme und Ergebnisse vorhersagen können, und all dies auf erschwinglichen Mikrocontroller-basierten Plattformen an der Netzwerkgrenze, wo die Daten erzeugt und erfasst werden.

Die Lösung ist, wie ich bereits erwähnt habe, NanoEdge AI Studio von Cartesiam.AI. Mit dieser integrierten Entwicklungsumgebung (IDE), die unter Windows 10 oder Linux Ubuntu läuft, wählt der Embedded-Entwickler zunächst den Ziel-Mikrocontroller aus, der von einem Arm-Cortex-M0 bis zu -M7 reicht. Außerdem gibt der Entwickler oder Designer die maximale Menge an RAM an, die der Lösung zugewiesen werden soll. Wenn Sie ein wenig eingerostet oder ein Neuling sind, ist das Arm-Cortex-M-Prototyping-System+ V2M-MPS2-0318C (Abbildung 1) ein guter Ort, um (wieder) anzufangen.

Das V2M-MPS2-0318C ist Teil der „Arm Versatile Express“-Reihe von Entwicklungsboards. Es wird mit einem relativ großen FPGA für die Prototypisierung von Cortex-M-basierten Designs geliefert. Zu diesem Zweck wird es mit fest verschlüsselten FPGA-Implementierungen aller Cortex-M-Prozessoren geliefert. Außerdem verfügt es über eine Reihe nützlicher Peripheriekomponenten, darunter PSRAM, Ethernet, Touchscreen, Audio, ein VGA-LCD, SPI und GPIO.

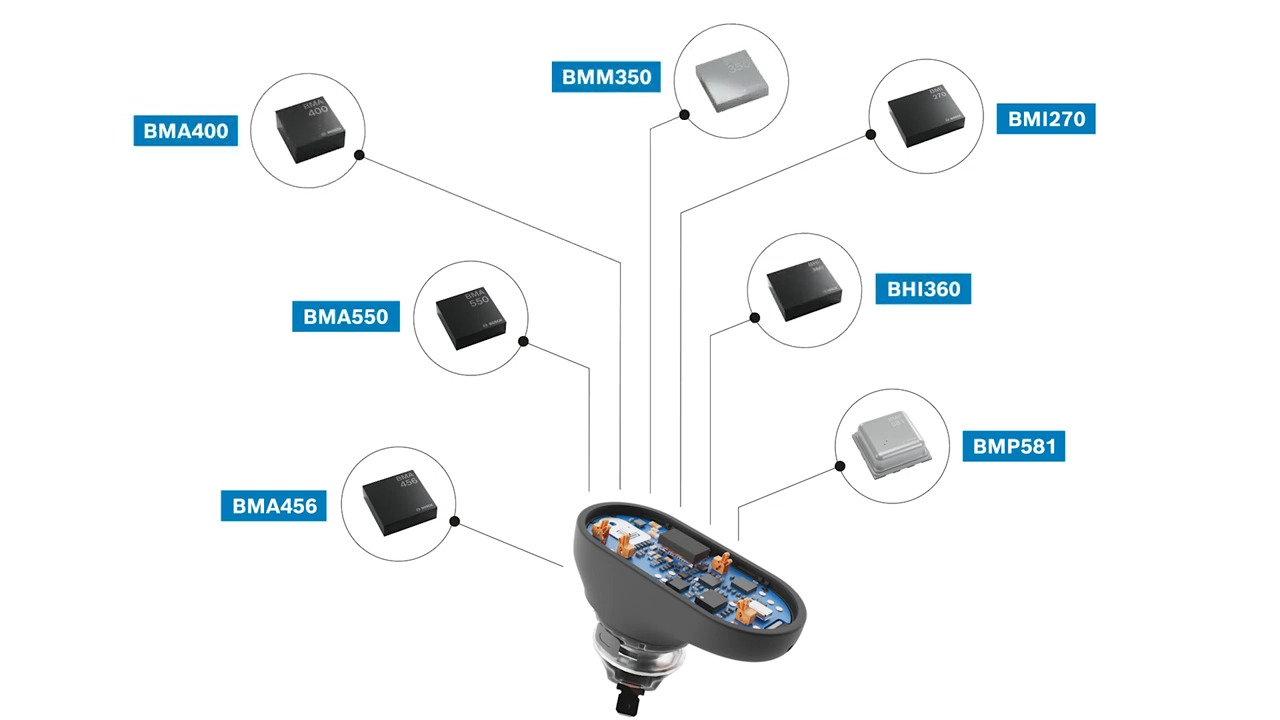

Als Nächstes muss der Entwickler die Anzahl und die Art der zu verwendenden Sensoren auswählen. Das Schöne am Cartesiam.AI-Ansatz ist, dass es keine harten Beschränkungen für die verwendbaren Sensoren gibt. Sie können zum Beispiel Folgendes umfassen:

- Ein-, zwei- und dreiachsige Beschleunigungsaufnehmer (im Grunde jede Frequenz für die Schwingungsanalyse)

- Magnetsensoren

- Temperatursensoren

- Mikrofone (für die Schallerfassung)

- Halleffekt-Sensoren für die Motorsteuerung

- Sensoren zur Stromüberwachung

Es ist wichtig zu beachten, dass der Entwickler nicht verpflichtet ist, bestimmte Teilenummern zu definieren - nur die allgemeinen Sensortypen.

Der nächste Schritt besteht darin, kontextbezogene Sensordaten zu laden, d.h. generische Daten, die mit jedem Sensor verbunden sind, um dem System eine Vorstellung davon zu geben, womit es zu tun haben wird.

NanoEdge AI Studio ist mit einer umfangreichen Suite von AI/ML-"Bausteinen" ausgestattet, mit denen sich Lösungen für 90 % oder mehr der industriellen AI/ML-Aufgaben erstellen lassen. Sobald sie über den Ziel-Mikrocontroller, die Anzahl und Arten von Sensoren und die zu erwartenden generischen Sensordaten informiert ist, wird sie die beste AI/ML-Bibliothekslösung aus 500 Millionen möglichen Kombinationen generieren.

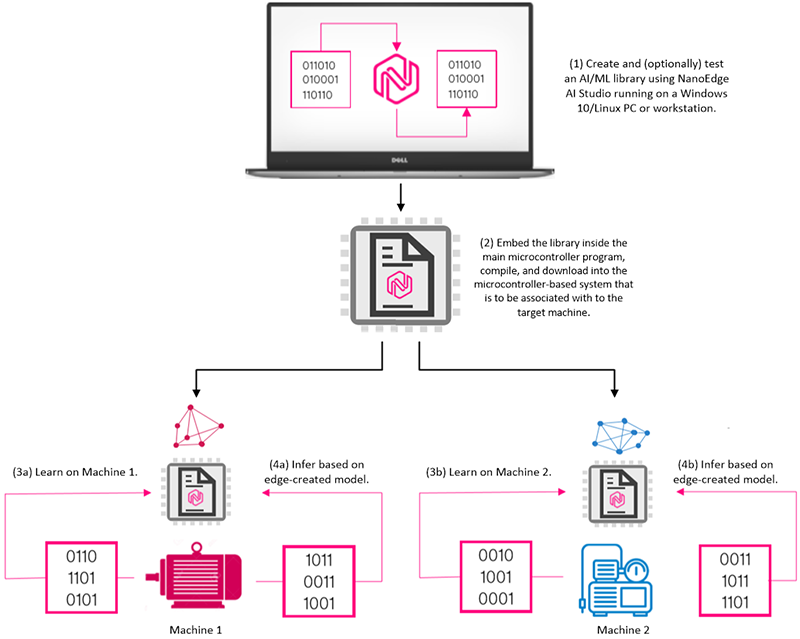

Wenn der Entwickler es wünscht, kann diese Lösung optional auf demselben PC getestet werden, auf dem die NanoEdge AI Studio IDE läuft. Danach wird sie in das Hauptprogramm des Mikrocontrollers eingebettet, kompiliert und in das Mikrocontroller-basierte System heruntergeladen, das mit dem Zielrechner verbunden werden soll.

Nur um eines Beispiels willen nehmen wir an, dass wir zwei dumme Maschinen haben, die wir intelligent machen wollen. Eine dieser Maschinen könnte eine Pumpe sein, während die andere ein Generator sein könnte. Nehmen wir für dieses Beispiel außerdem an, dass wir eine einzige Lösung mit einem Temperatursensor und einem 3-Achsen-Beschleunigungsmesser erstellen und dass die gleiche Lösung auf beiden Maschinen eingesetzt wird (Abbildung 2).

Abbildung 2: Nachdem die NanoEdge AI Studio IDE zum Erstellen und (optional) Testen einer AI/ML-Bibliothek verwendet wurde, wird diese Bibliothek in das Hauptprogramm eingebettet, kompiliert und in das Mikrocontroller-basierte System heruntergeladen, das mit dem/den Zielcomputer(n) verknüpft werden soll. Nach einer Lernphase (in der Regel eine Woche mit einem 24-Stunden-Betrieb) kann die Inferenzmaschine zur Erkennung und Meldung von Anomalien und zur Vorhersage künftiger Ergebnisse eingesetzt werden. (Bildquelle: Max Maxfield)

Abbildung 2: Nachdem die NanoEdge AI Studio IDE zum Erstellen und (optional) Testen einer AI/ML-Bibliothek verwendet wurde, wird diese Bibliothek in das Hauptprogramm eingebettet, kompiliert und in das Mikrocontroller-basierte System heruntergeladen, das mit dem/den Zielcomputer(n) verknüpft werden soll. Nach einer Lernphase (in der Regel eine Woche mit einem 24-Stunden-Betrieb) kann die Inferenzmaschine zur Erkennung und Meldung von Anomalien und zur Vorhersage künftiger Ergebnisse eingesetzt werden. (Bildquelle: Max Maxfield)

Natürlich werden diese beiden Maschinen völlig unterschiedliche Eigenschaften haben. In der Realität können zwei ansonsten identische Maschinen je nach Standort und Umgebung sehr unterschiedliche Eigenschaften aufweisen. Beispielsweise können zwei identische Pumpen, die 20 Meter voneinander entfernt im selben Raum derselben Fabrik aufgestellt sind, unterschiedliche Schwingungsprofile aufweisen, je nachdem, wo sie montiert sind (eine auf Beton, die andere über Holzbodenbalken) und je nach Länge (und Formen und Materialien) der Rohre, an die sie angeschlossen sind.

Der Schlüssel zum gesamten Prozess ist, dass die AI/ML-Lösungen individuell an bekanntermaßen guten Maschinen geschult werden, wobei dieses Training normalerweise eine Woche im Dauerbetrieb, 24 Stunden pro Tag, dauert, wodurch das System aus Temperaturschwankungen und Schwingungsmustern lernen kann. Zusätzliche Schulungen können natürlich zu einem späteren Zeitpunkt durchgeführt werden, um die Modelle feiner abzustimmen, um die mit verschiedenen Jahreszeiten (für externe Anwendungen) und anderen erwarteten Variablen verbundenen Umweltschwankungen zu berücksichtigen.

Sobald die Lösungen trainiert sind, können sie aus allen neu eintreffenden Daten Schlussfolgerungen ziehen, Muster erkennen und Anomalien aufdecken, Probleme und Ergebnisse vorhersagen und ihre Schlussfolgerungen je nach Bedarf auf einem Dashboard für technische und Management-Analysen präsentieren.

Fazit

Ich sehe NanoEdge AI Studio als eine weichenstellende Entwicklung. Sie ist intuitiv und ermöglicht es Entwicklern von eingebetteten Systemen, die energiesparende und kostengünstige Arm-Cortex-M-Mikrocontroller verwenden (die weltweit in Milliarden von Geräten eingebettet sind), AI/ML schnell, einfach und kostengünstig in ihre industriellen Systeme zu integrieren und so dumme Maschinen in intelligente Maschinen zu verwandeln, wodurch die Produktivität und Effizienz gesteigert und gleichzeitig die viel erwarteten Einsparungen bei den Betriebskosten erzielt werden.

Referenzen

1: https://www.vxchnge.com/blog/iot-statistics

2: https://securitytoday.com/articles/2020/01/13/the-iot-rundown-for-2020.aspx

3: https://www.helpnetsecurity.com/2019/06/21/connected-iot-devices-forecast/

4: https://securitytoday.com/articles/2020/01/13/the-iot-rundown-for-2020.aspx

5: https://www.kleinerperkins.com/perspectives/the-industrial-awakening-the-internet-of-heavier-things/

6: https://www.ibm.com/downloads/cas/3RL3VXGA

7: https://newsroom.cisco.com/press-release-content?articleId=1847422

8: https://www.idc.com/getdoc.jsp?containerId=US44363318

9: https://www.statista.com/statistics/935382/worldwide-microcontroller-unit-shipments/

Have questions or comments? Continue the conversation on TechForum, Digi-Key's online community and technical resource.

Visit TechForum