Das maschinelle Lernen ist da – Nutzen wir es mit Bedacht

Maschinelles Lernen (ML), ein Unterbegriff der künstlichen Intelligenz (KI), wird bereits effektiv in einigen Anwendungen genutzt, z. B. in der medizinischen Diagnose, Bildverarbeitung, Klassifizierung, Vorhersage und bei Regressionstests. Wenn ML in Betracht gezogen wird, bestehen allgemein zwei Arten von Sicherheitsbedenken: Sicherheit bei der Anwendung und Kompromittierung der Validität der Ergebnisse.

Abbildung 1: Das industrielle Internet der Dinge (Industrial Internet of Things, IIoT) ist vielfältig vernetzt und kann effizienter verwaltet werden, wenn das maschinelle Lernen Bestandteil des Systems ist. (Bildquelle: SlideShare.net)

Abbildung 1: Das industrielle Internet der Dinge (Industrial Internet of Things, IIoT) ist vielfältig vernetzt und kann effizienter verwaltet werden, wenn das maschinelle Lernen Bestandteil des Systems ist. (Bildquelle: SlideShare.net)

Sicherheitsangriffe auf die KI sind nicht neu, aber sie werden immer ausgefeilter. Die Angriffsfläche, die Anzahl der Punkte, an denen ein unberechtigter Benutzer verdeckt eindringen oder Daten abziehen kann, lässt sich ausbeuten. Drei Bereiche sind verwundbar: die Eingangsdaten, die Gestaltung der Algorithmen und die resultierenden Entscheidungen.

Maschinelles Lernen ist am erfolgreichsten, wenn auf große Datenmengen zugegriffen wird, von denen in einem Maß gelernt werden kann, das von Menschen nur schwer zu erreichen ist. Die Angriffe bestehen z. B. darin, dass trainierte Modelle durch Hintertüren „vergiftet“ werden oder dass bösartige Nutzdaten oder Auslöser eingeführt werden. In diesem KI-Segment sind die Algorithmen komplex und unvorhersagbar. Sie halten sich nicht an Standards und Vorschriften und basieren auf proprietären Daten, sodass Fälschungen nur sehr schwer entdeckt werden können.

Neben der Sicherheit bestehen Risiken auf einem weiteren Gebiet. Da Modelle beim maschinellen Lernen von Menschen geschaffen werden, kann das Modell von eingebauten Fehlern betroffen sein. Datenfehler sind gefährlich und müssen sorgfältig gehandhabt werden. Die Bewältigung solcher Fehler ist ein wichtiger Aspekt beim Umgang mit Risiken des maschinellen Lernens.

Zu den Risiken gehören auch unzureichende Daten und das Vorhandensein von guten bzw. geeigneten Daten. Ein Mangel an variablen Daten mit genügend vielen Datenpunkten, um die besten Eingaben für optimale Ausgangsdaten zu ermitteln, kann ein großes Problem darstellen. Die für Modelle des maschinellen Lernens zur Verfügung stehenden Daten sollten bezüglich Datentyp, Zeitrahmen und anderen Parametern variieren.

Dann sind da die Interpretationen der Ausgangsdaten. Die Ausgangsdaten können falsch interpretiert werden. Zwar bieten die Modelle Schätzungen und Leitlinien, aber es muss in Betracht gezogen werden, wie ein Modell aufgebaut wurde, welche Annahmen getroffen wurden und welche Form die Ausgangsdaten haben müssen, damit Interpretationen relevant sind.

Es wurden bereits viele Erfahrungen gemacht mit Dingen, die schief gehen können, z. B.:

- Algorithmen wurden für den Absturz des britischen Pfunds um 6 % innerhalb von zwei Minuten während des Brexit-Referendums im Jahre 2016 verantwortlich gemacht.

- In der Kriminalstatistik verwendete Algorithmen über die Rückfallhäufigkeit in den USA waren ethnisch verfälscht.

- Viele Ergebnisse von Studien zur Gehirnfunktion sind zweifelhaft, nachdem falsche statistische Annahmen und Fehler in der Bildgebung bei der funktionellen Magnetresonanztomographie (fMRI) entdeckt wurden.

- Als die Preise für Bitcoin im Jahre 2017 stark anstiegen, haben Hacker mithilfe der Google Cloud kostenlos geschürft. Das Anomalie-Erkennungssystem von Google Cloud wurde für Google Cloud-Instanzen eingesetzt, sodass Kunden vor der Kompromittierung gewarnt wurden.

Maschinelle Lernsysteme lösen schwierige Probleme. Der Tatsache, dass sie in Bezug auf Sicherheit und Genauigkeit negativ beeinflusst werden können, stehen Fortschritte bei der verwendeten Technologie und die wachsende Anzahl von Anwendungen gegenüber, die sie einsetzen.

Aktuelle Fortschritte beim maschinellen Lernen

STMicroelectronics hat vor Kurzem die erste Anwendung für maschinelles Lernen seines Partners Cartesiam, einem Mitglied des ST-Partnerprogramms für maschinelles Lernen, auf dem STM32G4 angekündigt. ST hat das Erweiterungspaket STM32Cube.AI herausgegeben. Entwickler können damit neuronale Netzwerke einfach durch Sammeln von Daten trainieren, bevor diese in einem Framework für neuronale Netze auf einem PC zur Erkennung von spezifischen Aktivitäten wie Gehen, Laufen oder Schwimmen verarbeitet werden. Die Ausgangsdaten werden dann in einen Code konvertiert, der es den STM32-MCUs ermöglicht, diese Aktivitäten zu erkennen.

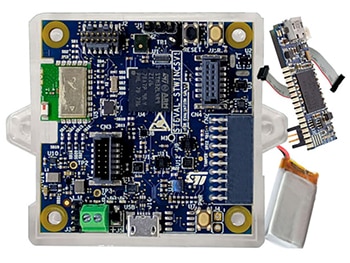

Abbildung 2: Abgebildet ist die Evaluierungskarte SensorTile von STMicroelectronics. (Bildquelle: STMicroelectronics)

Abbildung 2: Abgebildet ist die Evaluierungskarte SensorTile von STMicroelectronics. (Bildquelle: STMicroelectronics)

NanoEdge AI von Cartesiam führt die Lernphase auf dem Mikrocontroller aus. Die Entwickler greifen auf diese Lösung zurück, wenn sie keine geeigneten vortrainierten Modelle für bestimmte Situationen erstellen können, aber mithilfe von maschinellem Lernen zu eleganten Lösungen kommen möchten. Innerhalb der auf der MCU ausgeführten Trainingsphase wird das normale Verhalten einer Komponente in ihrer beabsichtigten Umgebung gelernt. Dann werden Inferenzen auf derselben MCU ausgeführt, um Verhaltensanomalien zu erkennen und zu melden.

Mit NanoEdge AI können die Entwickler lokales KI-Training und Analysemöglichkeiten in C-Programmcode integrieren, der dann für STM32-MCUs optimiert wird. In Vorführungen zeigte Cartesiam, wie seine Bibliotheken für maschinelles Lernen das SensorTile-Modul von STM, die SensorTile-Evaluierungskarte (Abbildung 2) einsetzen können, um das Verhalten eines bürstenlosen DC-Motors durch Vibrationsanalyse zu erlernen. Dank der eingebetteten STM32L4-MCU können die Anomalien dann erkannt und gemeldet werden.

Ein Core zum maschinellen Lernen befindet sich auch auf den erweiterten Sensorkarten von STMicroelectronics, z. B. auf der LSM6DSOX iNEMO. Der Core bietet zusammen mit einem endlichen Zustandsautomaten (Finite State Machine, FSM) und erweiterten digitalen Funktionen die Möglichkeit, bei batteriebetriebenen IoT-Geräten, Spielgeräten, Wearables und Unterhaltungselektronik von einem Zustand mit extrem niedrigem Energieverbrauch zu hochgenauen Hochleistungs-KI-Fähigkeiten überzugehen. Dabei werden typische Betriebssystemanforderungen unterstützt und reale, virtuelle und Batch-Sensoren mit 9 kB RAM für die dynamische Stapelverarbeitung von Daten bereitgestellt.

Künstliche Intelligenz und maschinelles Lernen faszinieren zwar noch immer in sämtlichen Erscheinungsformen, aber ihre Verwendung wird künftig durch eine Kombination von neuen Anwendungen, hervorragenden Ergebnissen und der Fähigkeit, Sicherheit zu gewährleisten, vorangetrieben.

Have questions or comments? Continue the conversation on TechForum, Digi-Key's online community and technical resource.

Visit TechForum