Wie Sensorfusion AMRs ein effizientes Manövrieren in Fabrikhallen ermöglicht

Zur Verfügung gestellt von Nordamerikanische Fachredakteure von DigiKey

2024-03-27

Mit der zunehmenden Anzahl von Menschen und autonomen mobilen Robotern (AMRs), auch mobile Industrieroboter (IMRs) genannt, die im selben Bereich arbeiten, müssen mehrere inhärente Sicherheitsrisiken berücksichtigt werden. Der sichere und effiziente Betrieb von AMRs ist zu wichtig, um sich auf eine einzige Sensortechnologie zu verlassen.

Bei der Multisensorfusion oder einfach „Sensorfusion“ werden Technologien wie Laserentfernungsmessung (LIDAR), Kameras, Ultraschallsensoren, Laser-Hindernis-Sensoren und Radiofrequenz-Identifikation (RFID) kombiniert, um eine Reihe von AMR-Funktionen zu unterstützen, z. B. Navigation, Streckenplanung, Kollisionsvermeidung, Bestandsmanagement und Logistikunterstützung. Die Sensorfusion umfasst auch die Alarmierung von Menschen in der Nähe über die Anwesenheit der AMRs.

Um der Notwendigkeit eines sicheren und effizienten Betriebs von AMRs gerecht zu werden, entwickeln das American National Standards Institute (ANSI) und die Association for Advancing Automation (A3), ehemals Robotic Industries Association (RIA), die Normenreihe ANSI/A3 R15.08. R15.08-1 und R15.08-2 wurden veröffentlicht und konzentrieren sich auf die grundlegenden Sicherheitsanforderungen und die Integration von AMRs in einen Standort. R15.08-3 wird derzeit entwickelt und wird die Sicherheitsanforderungen für AMRs erweitern, einschließlich detaillierterer Empfehlungen für den Einsatz von Sensorfusion.

Im Vorgriff auf R15.08-3 gibt dieser Artikel einen Überblick über einige der heutigen bewährten Methoden in Bezug auf Sicherheit und Sensorfusion in AMRs. Er beginnt mit einem kurzen Überblick über die Anforderungen an die funktionale Sicherheit, die derzeit für AMRs verwendet werden, einschließlich der allgemeinen industriellen Sicherheitsnormen wie IEC 61508, ISO 13849 und IEC 62061 sowie der Sicherheitsanforderungen für die Erkennung menschlicher Anwesenheit wie IEC 61496 und IEC 62998. Anschließend wird ein typischer AMR-Entwurf vorgestellt, in dem die zahlreichen Sensortechnologien detailliert beschrieben, repräsentative Geräte vorgestellt und untersucht werden, wie sie Funktionen wie Navigation, Streckenplanung, Lokalisierung, Kollisionsvermeidung und Bestandsmanagement/Logistikunterstützung unterstützen.

Gut, besser, am besten

Bei der AMR-Konstruktion muss eine Reihe von Sicherheitsnormen berücksichtigt werden, angefangen bei allgemeinen funktionalen Sicherheitsnormen wie IEC 61508, ISO 13849 und IEC 62061. Es gibt auch spezifischere Sicherheitsnormen, die sich auf die Erkennung der Anwesenheit von Personen beziehen, wie IEC 61496, IEC 62998 und die Normenreihe ANSI/A3 R15.08.

IEC 61496 bietet Leirfäden für verschiedene Sensortypen. Sie bezieht sich auf IEC 62061, die Anforderungen und Empfehlungen für den Entwurf, die Integration und die Validierung von elektrosensiblen Schutzeinrichtungen (BWS) für Maschinen, einschließlich Sicherheits-Integritätslevels (SILs), festlegt, sowie auf die ISO 13849, die die Sicherheit von Maschinen und sicherheitsbezogenen Teilen von Steuerungen, einschließlich Sicherheits-Performance-Levels (PLs), abdeckt (Tabelle 1).

|

|||||||||||||||||||

Tabelle 1: Sicherheitsanforderungen für ESPE nach Typ gemäß IEC 61496. (Tabellenquelle: Analog Devices)

IEC 62998 ist aktueller und kann oft die bessere Wahl sein, da sie Leitfäden zur Implementierung der Sensorfusion, zur Verwendung von künstlicher Intelligenz (KI) in Sicherheitssystemen und zur Verwendung von Sensoren auf beweglichen Plattformen außerhalb des Geltungsbereichs von IEC 61496 enthält.

R15.08 Teil 3, wenn sie veröffentlicht wird, könnte die R15.08-Serie zur besten machen, da sie zusätzliche Sicherheitsanforderungen für Benutzer von AMR-Systemen und AMR-Anwendungen enthält. Zu den wahrscheinlichen Themen gehören die Sensorfusion und umfassendere AMR-Stabilitätstests und -Validierung.

Funktionen der Sensorfusion

Die Kartierung der Einrichtung ist ein wesentlicher Aspekt der AMR-Inbetriebnahme. Aber das ist keine einmalige Sache. Es ist auch Teil eines fortlaufenden Prozesses, der als simultane Ortung und Kartierung (SLAM) bezeichnet wird, manchmal auch als synchronisierte Ortung und Kartierung. Es handelt sich um einen Prozess, bei dem die Karte eines Gebietes ständig aktualisiert wird, um etwaige Änderungen zu erfassen und gleichzeitig den Standort des Roboters zu verfolgen.

Die Sensorfusion ist notwendig, um SLAM zu unterstützen und den sicheren Betrieb von AMRs zu ermöglichen. Nicht alle Sensoren funktionieren unter allen Betriebsbedingungen gleich gut, und verschiedene Sensortechnologien erzeugen unterschiedliche Datentypen. KI kann in Sensorfusionssystemen eingesetzt werden, um Informationen über die örtliche Betriebsumgebung zu kombinieren (ist es dunstig oder rauchig, feucht, wie hell ist das Umgebungslicht usw.) und durch die Kombination der Ergebnisse verschiedener Sensortechnologien ein aussagekräftigeres Ergebnis zu erzielen.

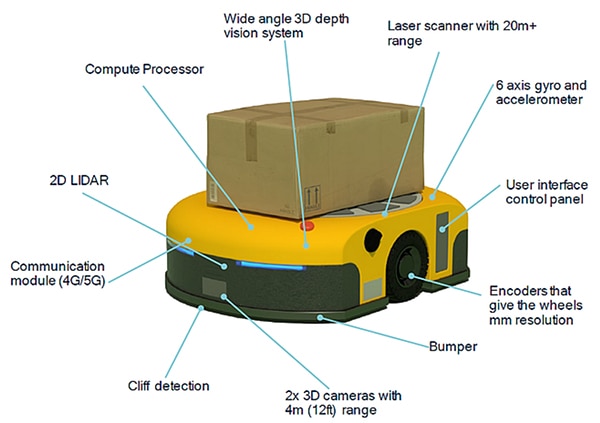

Sensorelemente können sowohl nach Funktion als auch nach Technologie kategorisiert werden. Beispiele für Sensorfusionsfunktionen in AMRs sind (Abbildung 1):

- Abstandssensoren wie Encoder an Rädern und Trägheitsmesseinheiten mit Gyroskopen und Beschleunigungsmessern helfen bei der Messung der Bewegung und der Bestimmung des Bereichs zwischen Referenzpositionen.

- Bildsensoren wie 3D-Kameras und 3D-LiDAR werden eingesetzt, um Objekte in der Nähe zu identifizieren und zu verfolgen.

- Kommunikationsverbindungen, Rechenprozessoren und Logistiksensoren wie Barcode-Scanner und RFID-Geräte verbinden den AMR mit anlagenweiten Managementsystemen und integrieren Informationen von externen Sensoren in das Sensorfusionssystem des AMR, um dessen Performance zu verbessern.

- Näherungssensoren wie Laserscanner und zweidimensionales (2D) LiDAR erkennen und verfolgen Objekte in der Nähe des AMR, einschließlich der Bewegungen von Personen.

Abbildung 1: Beispiele für gängige Sensortypen und zugehörige Systemelemente, die in AMR-Sensorfusionsdesigns verwendet werden. (Bildquelle: Qualcomm)

Abbildung 1: Beispiele für gängige Sensortypen und zugehörige Systemelemente, die in AMR-Sensorfusionsdesigns verwendet werden. (Bildquelle: Qualcomm)

2D-LiDAR, 3D-LiDAR und Ultraschall

2D- und 3D-LiDAR sowie Ultraschall sind gängige Sensortechnologien, die SLAM und Sicherheit in AMRs unterstützen. Die Unterschiede zwischen diesen Technologien ermöglichen es dem einen Sensor, die Schwächen des anderen auszugleichen und so die Performance und Zuverlässigkeit zu verbessern.

2D-LiDAR verwendet eine einzige Ebene der Laserbeleuchtung, um Objekte anhand von X- und Y-Koordinaten zu identifizieren. 3D-LiDAR verwendet mehrere Laserstrahlen, um eine sehr detaillierte 3D-Darstellung der Umgebung, eine so genannte Punktwolke, zu erstellen. Beide Arten von LiDAR sind relativ unempfindlich gegenüber den Lichtverhältnissen in der Umgebung, erfordern aber, dass die zu erfassenden Objekte eine Mindestschwelle für die Reflexion der vom Laser ausgestrahlten Wellenlänge aufweisen. Im Allgemeinen kann 3D-LiDAR Objekte mit geringer Reflektivität zuverlässiger erkennen als 2D-LiDAR.

Der 3D-LiDAR-Sensor HPS-3D160 von Seeed Technology integriert leistungsstarke 850nm-VCSEL-Infrarotlaseremitter (VCSEL = Vertical Cavity Surface Emitting Laser) und hochempfindliches CMOS. Der eingebettete Hochleistungsprozessor umfasst Filter- und Kompensationsalgorithmen und kann mehrere gleichzeitige LiDAR-Operationen unterstützen. Das Gerät hat eine Reichweite von bis zu 12 Metern mit Zentimetergenauigkeit.

Wenn eine 2D-LiDAR-Lösung benötigt wird, kann der TIM781S-2174104 von SICK verwendet werden. Er verfügt über einen Öffnungswinkel von 270 Grad mit einer Winkelauflösung von 0,33 Grad und einer Abtastfrequenz von 15 Hz. Er hat einen sicherheitsrelevanten Arbeitsbereich von 5 Metern (Abbildung 2).

Abbildung 2: Dieser 2D-LiDAR-Sensor hat einen Öffnungswinkel von 270 Grad. (Bildquelle: SICK)

Abbildung 2: Dieser 2D-LiDAR-Sensor hat einen Öffnungswinkel von 270 Grad. (Bildquelle: SICK)

Ultraschallsensoren können durchlässige Objekte wie Glas und lichtabsorbierende Materialien, die LiDAR nicht immer erkennen kann, genau erfassen. Ultraschallsensoren sind auch weniger anfällig für Störungen durch Staub, Rauch, Feuchtigkeit und andere Bedingungen, die LiDAR stören können. Ultraschallsensoren sind jedoch empfindlich gegenüber Störungen durch Umgebungsgeräusche, und ihre Erfassungsbereiche können begrenzter sein als bei LiDAR.

Ultraschallsensoren wie der TSPC-30S1-232 von Senix können LiDAR und andere Sensoren für AMR-SLAM und -Sicherheit ergänzen. Er hat eine optimale Reichweite von 3 Metern, verglichen mit 5 Metern für das 2D-LiDAR und 12 Metern für das oben beschriebene 3D-LiDAR. Dieser temperaturkompensierte Ultraschallsensor ist in einem Edelstahlgehäuse mit Schutzart IP68 untergebracht (Abbildung 3).

Abbildung 3: Gegen Umwelteinflüsse geschützter Ultraschallsensor mit einer optimalen Reichweite von 3 Metern. (Bildquelle: DigiKey)

Abbildung 3: Gegen Umwelteinflüsse geschützter Ultraschallsensor mit einer optimalen Reichweite von 3 Metern. (Bildquelle: DigiKey)

Die Sensorfusion bezieht sich in der Regel auf die Verwendung mehrerer diskreter Sensoren. In einigen Fällen werden jedoch mehrere Sensoren als eine einzige Einheit verpackt.

Drei Sensoren in einem

Die visuelle Wahrnehmung mit zwei Kameras, die stereoskopische Bilder erzeugen, sowie die Bildverarbeitung auf der Grundlage von KI und ML können es dem AMR ermöglichen, den Hintergrund zu erkennen und Objekte in der Nähe zu identifizieren. Es sind Sensoren erhältlich, die Stereo-Tiefenkameras, eine separate Farbkamera und eine Trägheitsmesseinheit (IMU) in einem Gerät enthalten.

Stereo-Tiefenkameras wie die RealSense-Tiefenkamera D455 von Intel verwenden zwei Kameras, die durch eine bekannte Basislinie getrennt sind, um die Tiefe zu erfassen und den Abstand zu einem Objekt zu berechnen. Ein Schlüssel zur Präzision ist die Verwendung eines stabilen Stahlrahmens, der einen exakten Abstand zwischen den Kameras gewährleistet, selbst in anspruchsvollen industriellen Umgebungen. Die Genauigkeit des Algorithmus zur Tiefenwahrnehmung hängt von der Kenntnis des genauen Abstands zwischen den beiden Kameras ab.

Das Tiefenkameramodell 82635DSD455MP wurde beispielsweise für AMRs und ähnliche Plattformen optimiert und der Abstand zwischen den Kameras auf 95 mm erweitert (Abbildung 4). Dies ermöglicht es dem Algorithmus zur Tiefenberechnung, den Schätzfehler auf weniger als 2 % bei 4 Metern zu reduzieren.

Abbildung 4: Dieses Modul umfasst Stereotiefenkameras mit einem Abstand von 95 mm, eine separate Farbkamera und eine Trägheitsmesseinheit. (Bildquelle: DigiKey)

Abbildung 4: Dieses Modul umfasst Stereotiefenkameras mit einem Abstand von 95 mm, eine separate Farbkamera und eine Trägheitsmesseinheit. (Bildquelle: DigiKey)

Die D455-Tiefenkameras enthalten auch eine separate Farbkamera (RGB). Ein globaler Shutter für bis zu 90 Bilder pro Sekunde auf der RGB-Kamera, der auf das Sichtfeld des Tiefenbilds abgestimmt ist, verbessert die Übereinstimmung zwischen den Farb- und Tiefenbildern und verbessert die Fähigkeit, die Umgebung zu verstehen. Die D455-Tiefenkameras verfügen über eine Trägheitsmesseinheit mit sechs Freiheitsgraden, die es dem Algorithmus zur Tiefenberechnung ermöglicht, die Bewegungsrate des AMR zu berücksichtigen und dynamische Schätzungen für die Tiefenwahrnehmung zu erstellen.

Beleuchtung und Beschallung des Weges

Blinkende Lichter und akustische Warnsignale für Personen in der Nähe eines AMR sind wichtig für die Sicherheit. Die Lichter sind in der Regel in Form eines Lichtmastes oder eines Lichtbandes an den Seiten des AMR angebracht. Sie helfen dem Roboter, den Menschen seine beabsichtigten Aktionen mitzuteilen. Sie können auch den Status anzeigen, z. B. das Aufladen der Batterie, Lade- oder Entladevorgänge, die Absicht, in eine neue Richtung abzubiegen (wie die Blinker eines Autos), Notfallbedingungen usw.

Es gibt keine Normen für Lichtfarben, Blinkgeschwindigkeiten oder akustische Alarme. Sie können von AMR-Hersteller zu AMR-Hersteller variieren und werden oft entwickelt, um die spezifischen Aktivitäten in der Einrichtung widerzuspiegeln, in der der AMR arbeitet. Lichtleisten sind mit und ohne eingebauten akustischen Warnmechanismus erhältlich. Das Modell TLF100PDLBGYRAQP von Banner Engineering verfügt beispielsweise über ein versiegeltes akustisches Element mit 14 wählbaren Tönen und Lautstärkeregelung (Abbildung 5).

Abbildung 5: Dieser Lichtbalkenmelder enthält ein versiegeltes akustisches Element (oberer schwarzer Kreis). (Bildquelle: DigiKey)

Abbildung 5: Dieser Lichtbalkenmelder enthält ein versiegeltes akustisches Element (oberer schwarzer Kreis). (Bildquelle: DigiKey)

Logistische Unterstützung

AMRs arbeiten als Teil größerer Betriebe und müssen oft in Software wie Enterprise Resource Planning (ERP), Manufacturing Execution System (MES) oder Warehouse Management System (WMS) integriert werden. Das Kommunikationsmodul auf dem AMR in Verbindung mit Sensoren wie Barcode- und RFID-Lesegeräten ermöglicht die enge Einbindung von AMRs in Unternehmenssysteme.

Wenn ein Barcodeleser benötigt wird, kann der V430-F000W12M-SRP von Omron verwendet werden, der 1D- und 2D-Barcodes auf Etiketten oder DPM-Barcodes (Direct Part Mark) decodieren kann. Er verfügt über einen Autofokus mit variablem Abstand, ein Objektiv mit weitem Sichtfeld, einen 1,2-Megapixel-Sensor, eine integrierte Beleuchtung und eine Highspeed-Verarbeitung.

Das DLP-RFID2 von DLP Design ist ein kostengünstiges, kompaktes Modul zum Lesen und Beschreiben von HF-RFID-Transponder-Tags. Es kann auch die UDI (Unique Identifier) von bis zu 15 Tags gleichzeitig lesen und kann für die Verwendung einer internen oder externen Antenne konfiguriert werden. Mit einem Betriebstemperaturbereich von 0°C bis +70°C eignet er sich für den Einsatz in Produktions- und Logistikanlagen für Industrie 4.0.

Fazit

Die Sensorfusion ist ein wichtiges Instrument zur Unterstützung von SLAM und Sicherheit in AMRs. Im Vorgriff auf R15.08-3, die möglicherweise Verweise auf die Sensorfusion und umfangreichere AMR-Stabilitätsprüfungen und -Validierungen enthält, wurden in diesem Artikel einige aktuelle Normen und bewährte Verfahren für die Implementierung der Sensorfusion in AMRs untersucht. Dies ist der zweite Artikel einer zweiteiligen Serie. Der erste Teil befasste sich mit der sicheren und effizienten Integration von AMRs in Industrie-4.0-Betriebe, um einen maximalen Nutzen zu erzielen.

Haftungsausschluss: Die Meinungen, Überzeugungen und Standpunkte der verschiedenen Autoren und/oder Forumsteilnehmer dieser Website spiegeln nicht notwendigerweise die Meinungen, Überzeugungen und Standpunkte der DigiKey oder offiziellen Politik der DigiKey wider.