Regen dämpft die Parade der autonomen Fahrzeuge

Elon Musk hat gesagt, dass Tesla plant, autonomes Fahren nur mit Hilfe von Kameras zu realisieren. Der Ansatz von Tesla steht im Gegensatz zu dem, was der Rest der Automobilindustrie tut. Die meisten autonomen Fahrsysteme beruhen auf einer Mischung aus Kameras, Radar und Lidar, um herauszufinden, was sich im Fahrweg eines Fahrzeugs befindet. Der Grund für diesen Multisensor-Ansatz liegt in der Überzeugung, dass nur mehrere Sensortechnologien Szenarien bewältigen können, die für spezifische Sensortechnologien verwirrend sind.

In Anbetracht der Position von Tesla bei der Kamerasensorik ist es interessant, einige der Probleme zu betrachten, mit denen die Sensoren autonomer Fahrzeuge trotz jahrelanger Tests und Forschung zu kämpfen haben. Zunächst zu den Kameras. Das klassische Beispiel für ein problematisches Szenario für Fahrzeugkameras ist, wenn ein Fahrzeug einen Hügel mit Blick auf die untergehende Sonne erklimmt. Das helle Sonnenlicht blendet die Kamera kurzzeitig, genauso wie es einen menschlichen Fahrer blenden könnte. Wenn das Fahrzeug den Berg hinunter in ein dunkles Tal fährt, kann die Kamera auch kurzzeitig blind sein, da sie eine Weile braucht, um sich an die relative Dunkelheit anzupassen.

Es gibt auch „Grenzfälle“, die Kameras verwirren können, nicht aber andere Arten von Sensoren. Im Sprachgebrauch der künstlichen Intelligenz sind Sonderfälle Situationen, die im wirklichen Leben vorkommen und auf die Algorithmen des maschinellen Lernens noch nicht gestoßen sind. Das klassische Beispiel für einen Grenzfall, der die Kamerasensoren verwirren könnte, ist das auf die Rückseite eines Lastwagens gemalte Bild. Die Kamera, die auf dem Auto hinter dem Lkw montiert ist, erkennt vielleicht nicht, dass die Szenerie nur ein Gemälde ist.

Möglicherweise gibt es Möglichkeiten, solche Schwierigkeiten zu umgehen, indem man nur die Kameratechnik einsetzt und eine Infrarotkamera hinzufügt. Aber es gibt noch ein weiteres Hindernis, das Kameras und andere Sensoren für autonomes Fahren plagt: schlechtes Wetter.

(Bildquelle: Littelfuse)

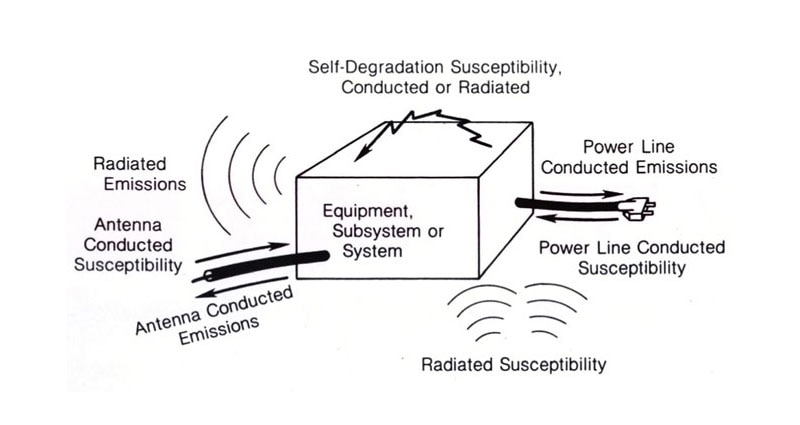

(Bildquelle: Littelfuse)

Ein einziger strategisch platzierter Wassertropfen (oder eine Schneeflocke) auf einem Objektiv kann eine Kamera unbrauchbar machen. Regentropfen, die nicht auf die Linse treffen, können dennoch Intensitätsunterschiede in Bildern und Videobildern erzeugen, die die Erkennung von Hindernissen erschweren. Insbesondere blockiert jeder Regentropfen einen Teil des Lichts, das sonst von den sichtbaren Objekten reflektiert wird. Regenstreifen verringern ebenfalls den Gesamtkontrast der Szene. Bei Tests, die vor einigen Jahren an der Michigan State University durchgeführt wurden, stellten Forscher fest, dass kamerabasierte Algorithmen bei leichtem Regen bis zu 20 % der Objekte nicht erkennen. Bei starkem Regen stieg die Fehlerquote bei bildverarbeitenden Algorithmen auf bis zu 40 %.

Es gibt Entwöhnungsalgorithmen, die kamerabasierten Systemen helfen, Objekte zu erkennen. Aber bisher haben sie nicht gut funktioniert. Ein Grund dafür: Diese Algorithmen wurden hauptsächlich an synthetischen Regenszenen getestet, die weitaus weniger komplex sind als die reale Situation.

Radar und Lidar haben ihre eigenen Probleme, wenn es darum geht, durch Regen oder Schnee zu navigieren. Es ist leicht zu verstehen, warum. Beide Erkennungsmechanismen stützen sich auf die von Objekten zurückgeworfenen Reflexionen, um zu lokalisieren und zu erkennen, was vor ihnen liegt. Wenn die Reflexionen von Regentropfen oder Schneeflocken zurückkommen, ist es schwer zu erkennen, was sich hinter dem Schnee und dem Regen verbirgt.

Es hat sich herausgestellt, dass leichter Regen dem Lidar nicht viel ausmacht. Starker Regen kann jedoch Klumpen bilden, die ein Lidar-Sensor als Hindernisse interpretieren kann. Außerdem haben Tests gezeigt, dass versprühter Regen, der nach einem Regensturm von anderen Fahrzeugen ausgeht, falsche Lidar-Ziele erzeugen kann. (Leser, die einen Vorgeschmack auf dieses Problem haben möchten, können sich vorstellen, einem großen Lkw während eines Gewitters auf einer Autobahn zu folgen) Dasselbe gilt für Schnee. Testdaten über das Verhalten von Lidar im Schnee sind spärlich, aber es gibt Hinweise darauf, dass Schnee falsche Ergebnisse erzeugen kann oder das Lidar daran hindern kann, Objekte zu sehen. Bei Tests in Finnland und Schweden wurde beispielsweise festgestellt, dass Schneewirbel, wie sie von einem vorausfahrenden Auto verursacht werden, im nachfolgenden Auto die Lidar-Messungen verfälschen können.

Radar schneidet bei Regen und Schnee besser ab als Lidar. Nasser Schnee scheint die meisten Probleme zu verursachen. Der größte Nachteil des Radars bei nassem Wetter scheint darin zu bestehen, dass Objekte mit kleineren Radarquerschnitten, wie Fußgänger, schlechter erkannt werden können.

Natürlich ist das autonome Erkennen von Fahrzeugen bei schlechtem Wetter immer noch ein Forschungsthema. Bei einem der untersuchten Ansätze werden zwei Sensoren anstelle von einem zur Erkennung von Objekten verwendet. Wenn ein Sensor ein Objekt erkennt und der andere nicht, versucht eine ausgeklügelte Mathematik herauszufinden, welcher der beiden richtig liegt. Wir vermuten, dass die Automobilhersteller von diesem speziellen System nicht begeistert sein werden, weil es die Anzahl der Sensoren im Fahrzeug erhöht, aber auch andere Ansätze finden Beachtung.

Letztendlich werden die Geräte der Autohersteller wahrscheinlich in der Lage sein, bei jedem Wetter zu sehen. Zumindest für Fahrzeuge könnte sich also die Abwandlung eines alten Zitats bewahrheiten: Es gibt kein schlechtes Wetter, nur schlechte Ausrüstung.

Have questions or comments? Continue the conversation on TechForum, Digi-Key's online community and technical resource.

Visit TechForum