Verkabelungslösung für die Rechenzentren von heute

Zur Verfügung gestellt von Nordamerikanische Fachredakteure von DigiKey

2024-12-23

Ähnlich wie Rohre Gas oder Öl transportieren, transportieren Kabel Daten, den Brennstoff für die Datenverarbeitung.

Die Art der Kabel, die Daten- und Kommunikationsgeräte benötigen, hängt von verschiedenen Faktoren ab, u. a. von der Art des Datenverkehrs und den Entfernungen, die sie zurücklegen. So leiten beispielsweise Kabel für die Datenspeicherung den Datenverkehr von Computern zu Speicher-Switches zu Speichereinheiten, während Kabel für den Netzwerkverkehr Daten von Computern zu Netzwerk-Switches zu Routern leiten. Der Telekommunikationsverkehr wird von Mobilfunkmasten oder Kabelboxen zu Zentralstellen geleitet. Für jedes dieser Systeme werden unterschiedliche Kabel benötigt.

Auch Entfernungen spielen eine Rolle - die Verkabelung kann über eine sehr kurze Strecke, innerhalb desselben Server-Racks oder zwischen verschiedenen Racks oder Räumen in einem Gebäude verlaufen. Andere Verkabelungen müssen jedoch auf dem gesamten Campus verlegt werden und kilometerweit reichen.

Im Laufe der Jahre sind Verkabelungsentscheidungen aufgrund einer übergreifenden Entwicklung immer wichtiger geworden: dem rasanten Wachstum von Rechenzentren.

Der Aufstieg der Rechenzentren

Die KI-Revolution läuft über Highspeed-Rechenzentren, die als Datenverarbeitungs-Backbone für Anwendungen dienen. Mit dem explosionsartigen Wachstum der KI wächst auch die Nachfrage nach Rechenzentren. Allein in den USA wird die Nachfrage nach Rechenzentren laut McKinsey bis 2030 um 10 % steigen. Darüber hinaus sind die Investitionsausgaben für Rechenzentren laut einem Bericht der Dell'Oro Group vor allem aufgrund der wachsenden Nachfrage nach KI-Servern allein im zweiten Quartal 2024 um fast 50 % gestiegen.

Um den unstillbaren Hunger nach Hochgeschwindigkeitsrechnern zu befriedigen, reicht ein Wachstum der Zahl der Rechenzentren allein nicht mehr aus. Außerdem wird ein besserer, schnellerer und höherer Durchsatz von Hochleistungsservern gefordert, sowohl für die Übertragung von Informationen innerhalb von Rechenzentren als auch zwischen ihnen über Verbindungsleitungen. Während 100-G-Netzwerke früher der Goldstandard waren, werden 400-G-Implementierungen jetzt immer mehr zur Routine, da IIoT, Cloud Computing und KI ihre Einführung vorantreiben. Eine weitere Entwicklung im Rechenzentrum, die es zu beobachten gilt, ist der wachsende Ruf nach einem geringeren Energieverbrauch. Das bedeutet, dass die Datenübertragungsgeschwindigkeit erhöht und energieeffizienter gestaltet werden muss.

Was bedeutet dieser Bedarf an größeren, besseren, schnelleren und energieeffizienteren Computern für die Verkabelung von Rechenzentren? Im Grunde genommen müssen Kabel Daten schnell und mit geringer Latenzzeit transportieren, ohne dass Datenpakete verloren gehen oder zu viel Strom verbraucht wird. Außerdem muss das Kabel diese Aufgabe erfüllen, ohne zu viel Wärme zu erzeugen, denn auch die Kühlung erfordert Energie.

In einem Rechenzentrum gibt es zwar Dutzende von Gerätetypen, darunter Netzwerk-, Kühl-, Speicher- und Stromversorgungssysteme, doch in diesem Artikel liegt der Schwerpunkt auf der Verkabelung der Hardwarekomponenten eines typischen Rechenzentrums-Racks. Dazu gehören z. B. Switches, die wie eine Verkehrssteuerung funktionieren, und Transceiver, die die Daten von einem System in ein anderes umwandeln.

Kabel für die Rechenzentren von heute

Drei Arten von Kabeln werden üblicherweise für hochvolumige Kommunikation verwendet, z. B. mit einer Kapazität von 10 Gbit/s oder, als modernste Variante, 400 Gbit/s. Eine typische Internetverbindung zu Hause hat weniger als 1 Gbit/s.

Das CAT6-Kabel: Das in Computernetzwerken zur Übertragung von Ethernet-Frames übliche CAT6-Kabel verwendet RJ45-Stecker. Für den Anschluss an einen Switch wird ein RJ45-Transceiver verwendet, der die Signale des Switches in RJ45-kompatible Signale umwandelt und am anderen Ende wieder zurückwandelt. Seine Latenzzeit beträgt etwa 2,6 ns, und er kann etwa 100 m weit übertragen. Die Leistungsaufnahme des Transceivers beträgt etwa 4 W.

Lichtwellenleiter: Die in der Video- und Audiokommunikation gebräuchlichen Glasfasern werden auch in der Netzwerk- und Datenkommunikation eingesetzt. Es verwendet optische Anschlüsse und benötigt einen Transceiver, der Strom in Licht und dann wieder in Strom umwandelt. Nach der Umwandlung in Licht beträgt die Latenzzeit der Glasfaser etwa 0,1 ns, und die Glasfaser kann Hunderte von Metern lang sein. Allerdings ist sie sehr wählerisch: Die Glasfaser enthält Glas oder Kunststoff, das sich nicht gerne biegt, und wenn sich am Ende ein Staubkorn absetzt, sinkt die Kapazität. Außerdem ist es teuer, insbesondere wenn man den optischen Transceiver hinzufügt, der den Stromverbrauch um etwa 4 W erhöht.

Direkt angeschlossenes Kupferkabel (DAC): DAC ist die einfachste und unproblematischste Verkabelungsoption. Es besteht aus Kupferleitungen und eignet sich am besten für Anwendungen mit kurzen Entfernungen, z. B. für Komponenten innerhalb desselben Racks. Das DAC ist preiswert und flexibel und kann ohne Transceiver verwendet werden, wenn kompatible Geräte angeschlossen werden, aber es ist nur für wenige Meter gut. Außerdem sollte das DAC nicht in der Nähe von Netzteilen, großen Batterien oder Magneten betrieben werden, da es zu Störungen kommen kann.

DACs gibt es in passiver und aktiver Ausführung. Das passive DAC hat keine Transceiver, und da die Übertragung passiv ist, überträgt es das ursprüngliche Signal unverändert. Das Fehlen von Transceivern trägt dazu bei, den Stromverbrauch auf ein Minimum zu reduzieren.

Ein aktives DAC verfügt über eingewebte Transceiver, die auch potenzielle Signalverluste kompensieren, was es zu einer sicheren Lösung für Langstreckenanwendungen in einem Rechenzentrum macht. Das Hinzufügen von elektronischen Elementen wie Transceivern erhöht den Stromverbrauch des aktiven DAC ein wenig, in der Regel um etwa 1 W.

Die Vorteile von DAC für Rechenzentren

In einem Rechenzentrum muss die Latenzzeit - also die Zeit, die Daten benötigen, um von einer Quelle zur anderen zu gelangen - so kurz wie möglich sein. Viele zeitkritische Anwendungen, wie z. B. autonome mobile Roboter (AMR) in Lagerhäusern oder Day-Trading in der Finanzbranche, müssen in Sekundenbruchteilen ausgeführt werden. Der größte Vorteil des DAC ist seine geringe Latenzzeit. Diese entscheidende Eigenschaft des DAC ist eine direkte Folge seiner Einfachheit. Es gibt keine komplexen Zwischenkomponenten, die von den Daten durchlaufen werden müssen, wodurch die Entwürfe weniger komplex und einfacher zu pflegen sind.

Das DAC ist zudem eine kostengünstige Verkabelungsoption, und insbesondere das passive DAC verbraucht sehr wenig Strom. Die größte Einschränkung ist die Länge, über die diese Kabel ohne allzu große Signalverschlechterung betrieben werden können, in der Regel etwa ein paar Meter. Das DAC ist nicht besonders effizient für die Datenübertragung über große Entfernungen, sondern eignet sich am besten für Kurzstreckenverbindungen innerhalb desselben Racks oder zwischen Racks. Aufgrund seiner Biegefähigkeit eignet es sich besonders gut für dichte Verbindungen, die untereinander und um enge Ecken herum verlegt werden müssen.

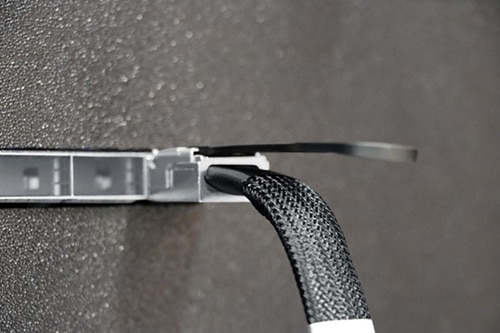

Die QSFP-DD-DAC-Kabelkonfektionen der 9V4-Serie 400G von 3M (Abbildung 1) nutzen die 3M-Twinaxial-Kabeltechnologie, um eine flexible, faltbare und leistungsstarke Lösung zu schaffen. Besonders hervorzuheben ist der QSFP-DD-Formfaktor (Quad Small Form-Factor Pluggable Double Density), ein Hardware-Standard, der schnellere Verbindungen ermöglicht. SFP bedeutet, dass das Kabel eine Standardform und -größe hat, die in Netzwerkgeräte eingesteckt werden kann; das „Quad“ weist auf die vier Datenkanäle hin, die das Kabel unterstützen kann; und die doppelte Dichte ermöglicht es, dass die doppelte Datenmenge durch einen Anschluss derselben physischen Größe fließt.

Abbildung 1: Die QSFP-DD-DAC-Kabelkonfektionen der 9V4-Serie 400G von 3M sind besonders wertvoll für Kurzstreckenverbindungen mit geringer Latenz innerhalb desselben Racks oder zwischen Racks in Datenzentren. (Bildquelle: 3M)

Abbildung 1: Die QSFP-DD-DAC-Kabelkonfektionen der 9V4-Serie 400G von 3M sind besonders wertvoll für Kurzstreckenverbindungen mit geringer Latenz innerhalb desselben Racks oder zwischen Racks in Datenzentren. (Bildquelle: 3M)

Das Ergebnis ist, dass QSFP-DD-DAC-Kabel der 9V4-Serie 400G von 3M die besten ihrer Klasse sind, um Bandbreiten von bis zu 400 Gbit/s für den Anschluss von Servern, Switches, Speichergeräten und anderen Highspeed-Geräten zu ermöglichen.

Überlegungen zur DAC-Verkabelung in Rechenzentren

Da das passive DAC die wirtschaftlichste und latenzärmste Lösung für Rechenzentren ist, lohnt es sich, darüber nachzudenken, wie es in die Racks der Rechenzentrumsinfrastruktur integriert werden kann.

Einige wichtige Faktoren sind zu berücksichtigen:

- Kompatibilität mit der Hardware: Da die Kabel mit Transceivern, Switches, Routern usw. verbunden werden müssen, ist es wichtig, dass die ausgewählten Kabel mit den vorhandenen Systemen kompatibel sind und auch an künftige Iterationen angepasst werden können. Das QSFP-DD-DAC-Kabel der 9V4-Serie 400G von 3M ist mit den meisten modernen Ausrüstungen kompatibel. Für den Fall, dass Rechenzentren einen Port mit hoher Kapazität in mehrere Verbindungen mit geringerer Kapazität aufteilen müssen (z. B. vier 100-Gbit/s- oder acht 50-Gbit/s-Verbindungen von einem 400-Gbit/s-Port), bietet die Serie auch Abzweigkabelkonfektionen an.

- Erhalt der Datensignale: Bei der Konstruktion von DAC muss berücksichtigt werden, dass die Kabel besonders anfällig für elektromagnetische Störungen (EMI) sind, insbesondere von Netzkabeln und -leitungen. Daher müssen die DAC-Datenkabel deutlich von den entsprechenden Stromkabeln getrennt werden.

- Leichter Zugang für die Wartung: Die Kabel sollten so verlegt werden, dass sie für Wartungstechniker leicht zugänglich sind. Eine Überkopfverkabelung, bei der das DAC von der Decke des Raumes herabhängt, wird in der Regel als die bessere Option für den Zugang angesehen, da das Kabel für die Verbindungen nicht zu lang oder übermäßig gekrümmt sein muss.

- Effiziente Belüftung und Kühlung: Technologie-Stacks geben viel Wärme ab, und die Belüftungspläne müssen bei der Verwaltung der DAC-Verkabelung berücksichtigt werden. Dies kann sich auf die Gerätedichte und den damit verbundenen Verkabelungsbedarf auswirken.

- Skalierbarkeit: Technologie-Stacks ändern sich, und die DAC-Verkabelung muss sich an solche Änderungen anpassen können. Die Gruppierung von Kabeln und deren effiziente Kennzeichnung und Bündelung hilft den Technikern, ganze Komponenten gemeinsam zu verwalten, anstatt jede einzelne aussortieren zu müssen.

Fazit

Da sich die Datenverarbeitung weiterentwickelt, um Platz für Edge-KI, mehr Virtualisierung und hyperkonvergente Umgebungen zu schaffen, werden sich auch die Anforderungen an die entsprechende Hardwareausrüstung ändern.

In Zukunft wird wahrscheinlich mehr Hardware für maschinelles Lernen, Edge-Rechenzentren und verteilte Infrastrukturen zum Einsatz kommen. Auch Hardware mit fortschrittlichen Sicherheits- und Nachhaltigkeitsfunktionen ist nicht mehr weit entfernt. Trotz alledem wird das DAC wahrscheinlich weiterhin das Kabel der Wahl sein, insbesondere bei kurzen Verbindungen in Racks. Die laserschnelle Latenzzeit und die Gesamtkostenökonomie sind unschlagbar. Daher wird das DAC auch weiterhin im Rechenzentrum und darüber hinaus von Nutzen sein.

Haftungsausschluss: Die Meinungen, Überzeugungen und Standpunkte der verschiedenen Autoren und/oder Forumsteilnehmer dieser Website spiegeln nicht notwendigerweise die Meinungen, Überzeugungen und Standpunkte der DigiKey oder offiziellen Politik der DigiKey wider.